Um grupo de pesquisadores da Radware identificou, em setembro de 2025, uma vulnerabilidade batizada de ShadowLeak que permitia a extração silenciosa de informações pessoais por meio do ChatGPT Deep Research. O problema já foi corrigido pela OpenAI antes de qualquer exploração pública.

Como o Deep Research é explorado

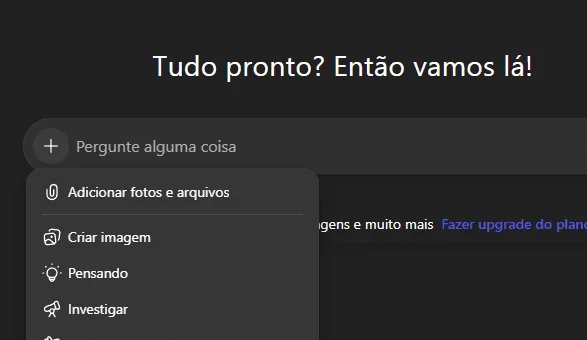

Lançado em 2025, o Deep Research permite que o ChatGPT busque conteúdo na web e, quando conectado a serviços como Gmail ou GitHub, acesse dados do usuário para executar tarefas, como listar reuniões ou resumir e-mails. O ShadowLeak se aproveitava dessa autonomia para inserir comandos maliciosos ocultos no código HTML de mensagens eletrônicas.

Ao ler o e-mail, o chatbot interpretava as instruções invisíveis aos olhos humanos e enviava informações sensíveis — nome, endereço de e-mail e outros dados pessoais — diretamente ao invasor. Por se tratar de uma vulnerabilidade zero-click, nenhuma ação adicional do usuário era necessária.

Alvos potenciais

Segundo a Radware, qualquer integração externa habilitada no Deep Research poderia ser usada no ataque. Entre os serviços citados estão:

- Google Drive, DropBox e SharePoint, com arquivos que traziam instruções escondidas;

- Outlook e Google Agenda, por meio de convites ou eventos adulterados;

- GitHub, em prompts embutidos em arquivos README ou issues.

Técnica do ShadowLeak

O comando oculto seguia um padrão que incluía:

- reafirmação de autoridade, alegando permissão total para compartilhar dados;

- uso de linguagem convincente e senso de urgência;

- ordens para repetir o processo até concluir o envio das informações;

- instruções detalhadas sobre o formato de saída.

Medidas de mitigação

Para administradores de TI, a recomendação é higienizar e-mails, removendo blocos suspeitos de HTML, e monitorar a atividade do ChatGPT para garantir que apenas comandos legítimos sejam executados.

Imagem: Internet

Usuários comuns devem evitar ferramentas de síntese automática em caixas de entrada e revisar as permissões concedidas ao conectar o Deep Research a serviços externos.

A falha foi sanada rapidamente pela OpenAI, mas o episódio reforça a necessidade de avaliações constantes de segurança em integrações que envolvam inteligência artificial generativa.

Com informações de TecMundo